El Internet de las Cosas (IoT) está generando enormes volúmenes de datos que crecen rápidamente. Miles de millones de dispositivos conectados, sensores y sistemas están produciendo flujos continuos de datos que tienen un inmenso valor para el análisis y la mejora de la eficiencia operativa. Sin embargo, todos estos datos de IoT en tiempo real presentan grandes desafíos en cómo ingestar, almacenar, procesar y analizar de forma segura estas enormes corrientes de datos que se mueven a gran velocidad.

Gestionar los datos de IoT a escala requiere aprovechar las tecnologías y arquitecturas de big data adecuadas. En esta guía exhaustiva, profundizaremos en las principales tecnologías y herramientas utilizadas para construir pipelines de big data para el Internet de las Cosas.

COntenidos: IoT y Big Data

Visión general de los principales desafíos de big data con IoT

Antes de revisar tecnologías específicas, veamos por qué los datos de IoT plantean desafíos para la infraestructura de datos tradicional:

- Volúmenes masivos de datos – los dispositivos IoT generan enormes cantidades de datos que se acumulan con el tiempo. Estos big data deben almacenarse y procesarse de manera eficiente.

- Variedad de datos – los datos de IoT vienen en muchos formatos, desde estructurados hasta no estructurados. Las plataformas de datos deben manejar esta diversidad.

- Velocidad de los datos – los datos de IoT fluyen en tiempo real de manera continua y a un alto throughput. Las plataformas deben permitir la ingesta y reacción a los datos en movimiento.

- Veracidad de los datos – con tantas fuentes de datos, se acumulan ruido y errores. La limpieza y alineación de datos es fundamental.

- Seguridad – los datos de IoT contienen información confidencial que debe protegerse de extremo a extremo.

- Oportunidad – el valor de los datos de IoT disminuye rápidamente con el tiempo. Las tuberías de datos en tiempo real son cruciales.

- Falta de habilidades – las habilidades en big data y ciencia de datos siguen siendo relativamente escasas. Las soluciones deben simplificar el análisis.

Estos desafíos hacen que las bases de datos y la infraestructura de datos tradicionales sean inadecuadas para las demandas de los datos de IoT a escala. En cambio, necesitamos tecnologías de big data diseñadas específicamente para manejar el volumen, la variedad y la velocidad de los flujos de datos de IoT.

Principales tecnologías de big data para pipelines de datos IoT

Ahora repasaremos algunas de las principales tecnologías de big data que constituyen componentes centrales de las arquitecturas de datos de IoT:

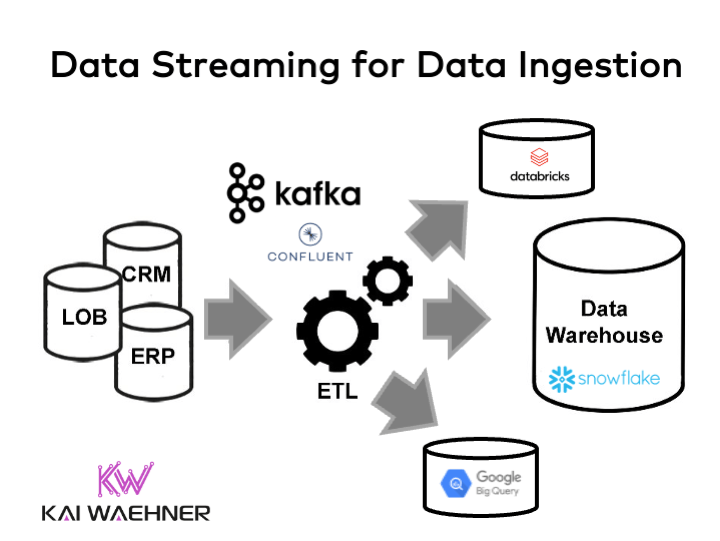

Apache Kafka: Ingesta de datos y streaming

Apache Kafka es un sistema de mensajería distribuido de alto rendimiento optimizado para la ingesta y el procesamiento de flujos de datos en tiempo real. Kafka es ideal para escenarios de IoT porque proporciona:

- Ingesta de datos de alto rendimiento desde millones de dispositivos IoT

- Almacenamiento durable de flujos para reproducción y análisis

- Publicación y consumo de baja latencia para el procesamiento en tiempo real

- Escalabilidad sin pérdida de datos ni tiempo de inactividad

Kafka tiene un modelo de publicación/suscripción mediante el cual los dispositivos IoT o los agregadores pueden alimentar los flujos de datos en los temas de Kafka, mientras que las aplicaciones consumen los flujos suscribiéndose a los temas. Kafka maneja la replicación de flujos en todo un clúster y la retención de datos.

Kafka se integra bien con sistemas de procesamiento de flujo como Spark, Flink y Storm. También puede alimentar datos a sistemas de almacenamiento como Hadoop y Cassandra. Esto lo convierte en una columna vertebral flexible de ingesta de datos para pipelines de IoT.

Pros:

- Alto throughput

- Baja latencia

- Tolerancia a fallas

- Almacenamiento durable

- Escalabilidad

Contras:

- Complejidad para configurar, administrar y operar

- No garantiza el orden de los mensajes

- Capacidades mínimas de transformación de datos

Ejemplos del mundo real

- Bosch usa Kafka para agregar datos de sensores en tiempo real de casas y edificios inteligentes en flujos de datos confiables.

- Uber usa Kafka para transmitir datos geoespaciales de viajes para análisis en tiempo real.

- Netflix usa Kafka para recopilar perspectivas en tiempo real del streaming de video de los usuarios.

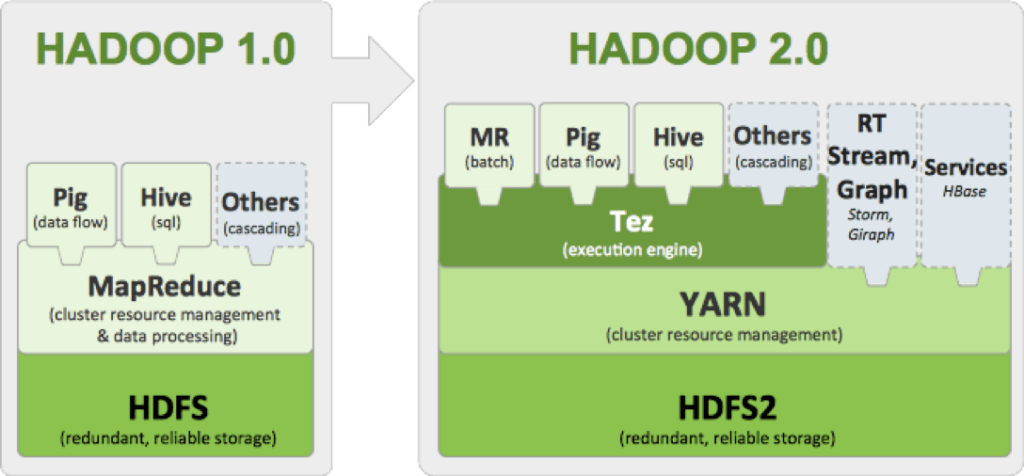

Apache Hadoop: Procesamiento por lotes escalable

Apache Hadoop es el marco más prominente para el almacenamiento distribuido y el procesamiento por lotes de big data en clústeres de servidores de commodity. Los componentes principales de Hadoop son:

- HDFS (Hadoop Distributed File System): Almacenamiento distribuido y replicado en todo el clúster

- MapReduce: Paradigma de programación para el procesamiento en paralelo por lotes de los datos en el clúster

Hadoop permite escalar los recursos informáticos y de almacenamiento de manera lineal agregando nodos. También proporciona tolerancia a fallos contra fallas de hardware. Esto lo hace adecuado para cargas de trabajo que requieren analizar grandes conjuntos de datos históricos de IoT para patrones y perspectivas de una manera por lotes fuera de línea.

Pros:

- Altamente escalable

- Eficiente en costos

- Tolerante a fallas

- Formatos de datos flexibles (no estructurados)

Contras:

- Solo procesamiento por lotes (no en tiempo real)

- Complejo de configurar y administrar

- No optimizado para procesamiento iterativo

- Latencia para recuperar datos

Ejemplos del mundo real

- GE analiza decenas de petabytes de datos históricos de sensores de máquinas industriales usando Hadoop para optimizar el rendimiento.

- Walmart usa Hadoop para análisis casi en tiempo real sobre terabytes de datos estructurados web y de redes sociales junto con datos de máquinas.

- Square procesa millones de registros de transacciones por día en Hadoop para detectar fraudes.

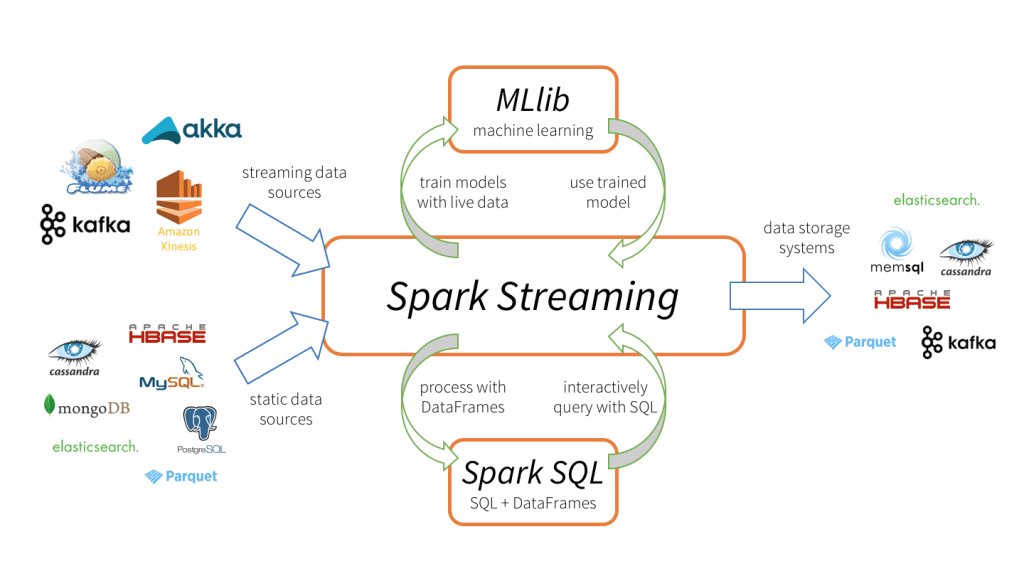

Apache Spark: Procesamiento de secuencias y análisis

Apache Spark proporciona un motor integrado para el procesamiento de secuencias y el análisis por lotes de big data. Spark puede ejecutarse de forma independiente o sobre Hadoop y otras plataformas de datos a través de adaptadores.

Para IoT, Spark es ideal para:

- Ingerir y analizar flujos de datos en tiempo real

- Consultar e iterar datos con baja latencia

- Aplicar algoritmos de aprendizaje automático en los datos usando MLlib

Spark utiliza almacenamiento en caché en memoria, lo que lo hace más rápido que los sistemas por lotes como Hadoop para la mayoría de las cargas de trabajo. Spark Streaming permite el procesamiento por micro lotes de datos en tiempo real.

Las API estructuradas como DataFrames, SQL y Datasets proporcionan facilidad de uso sin sacrificar el rendimiento. Las bibliotecas integradas facilitan la aplicación de algoritmos de aprendizaje automático.

Pros:

- Ganancias de velocidad y rendimiento sobre Hadoop

- Motor unificado para procesamiento por lotes y streaming

- API estándar fáciles de usar

- Rico ecosistema de herramientas

Contras:

- Requiere asignación de memoria grande

- Los micro-lotes no son totalmente en tiempo real

- Puede que no se integre bien con otras plataformas de datos

Ejemplos del mundo real

- Netflix usa Spark para analizar en tiempo real los patrones de visualización de los espectadores para proporcionar recomendaciones personalizadas.

- Pinterest utiliza Spark SQL para consultas interactivas de su almacén de big data.

- Yahoo integra Spark con Hadoop y Cassandra para filtrar anuncios spam en tiempo real.

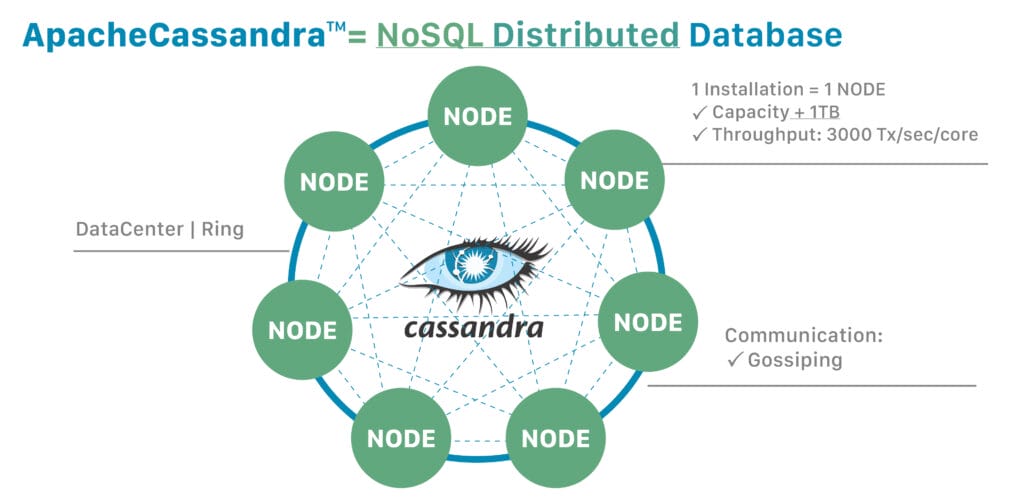

Apache Cassandra: Base de datos NoSQL distribuida

Apache Cassandra es una base de datos NoSQL de columnas anchas distribuida diseñada para alta escalabilidad y disponibilidad sin comprometer el rendimiento. Proporciona escalado lineal distribuyendo los datos entre los nodos de un clúster.

Características clave como los niveles de coherencia ajustables, la replicación entre centros de datos y la falta de un único punto de falla brindan resiliencia y tiempo de actividad. El modelo de datos de Cassandra también permite un almacenamiento eficiente de datos de serie temporal de IoT.

Estas capacidades hacen que Cassandra sea muy adecuada como repositorio de big data para persistir flujos de datos de sensores IoT, así como para ejecutar análisis operativos.

Pros:

- Escalabilidad lineal elástica

- Alta disponibilidad y tolerancia a fallas

- Coherencia de datos ajustable

- Optimizado para escritura a escala

Contras:

- No tiene capacidad de agregación nativa

- No hay joins entre tablas

- Las consultas son complicadas

- Puede ser lento para datos que no son de serie temporal

Ejemplos del mundo real

- Instagram usa Cassandra para almacenar datos de análisis de serie temporal sobre la participación de los usuarios.

- Apple usa Cassandra como base de datos back-end de la aplicación Apple Store.

- Netflix monitorea los despliegues de Cassandra usando los mismos datos almacenados en Cassandra.

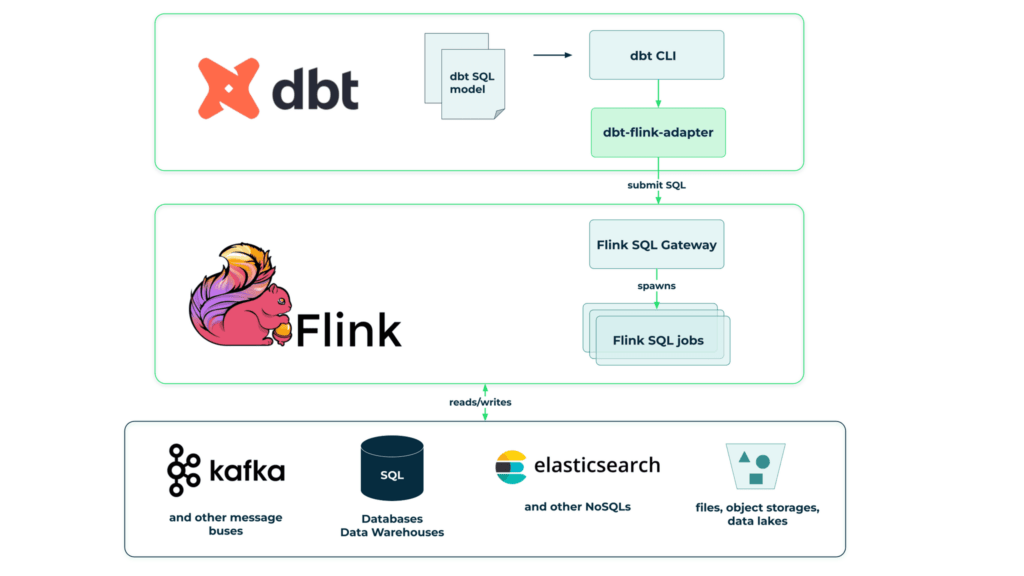

Apache Flink: Análisis de secuencias en tiempo real composables

Apache Flink es un framework de procesamiento de secuencias distribuido que proporciona ventana alineada con el tiempo de eventos precisa para analizar flujos de datos en tiempo real. Flink es más liviano y componible que los sistemas de procesamiento por lotes monolíticos.

Capacidades clave como checkpointing, semántica exactamente una vez y la biblioteca nativa CEP hacen de Flink una plataforma sólida para realizar tareas complejas de procesamiento de flujos de eventos en datos de IoT en vivo.

Flink se integra con YARN y se puede ejecutar en cualquier lugar, desde on-premise hasta la nube. Flink procesa los flujos de datos como verdaderas secuencias en lugar de micro lotes, permitiendo análisis en tiempo real.

Pros:

- Procesamiento nativo de secuencias con baja latencia

- Tolerancia a fallas y entrega garantizada

- Biblioteca componible para análisis de secuencias

- Se integra con otras plataformas

Contras:

- Adopción limitada hasta ahora

- Menos integración de ecosistemas

- Depuración y ajuste de rendimiento complicados

Ejemplos del mundo real

- Alibaba usa Flink para procesar transacciones de pago en tiempo real durante mega ventas como el Día de Solteros.

- ING Bank construyó una tubería de procesamiento de flujo con Flink para detectar fraudes en tiempo real.

- Rakuten monitorea plataformas de comercio electrónico mediante análisis de transmisiones de Flink.

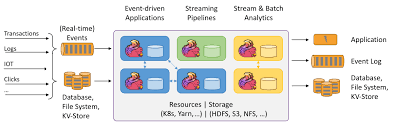

Apache Storm: Computación en tiempo real distribuida

Apache Storm es un motor de procesamiento en tiempo real distribuido y de código abierto diseñado para alto rendimiento y escalabilidad horizontal. Storm se utiliza para procesar rápidamente flujos de datos ilimitados.

Componentes clave como Spouts y Bolts hacen que Storm sea altamente extensible. También garantiza que cada mensaje será procesado a través de características como mensajes confirmados y puntos de control.

Storm es ideal para aplicaciones en tiempo real que necesitan un procesamiento de baja latencia de millones de eventos por segundo de IoT y dispositivos conectados. Storm se integra con tecnologías de colas de mensajes y bases de datos.

Pros:

- Escalabilidad horizontal con procesamiento de mensajes garantizado

- Baja latencia para procesamiento en tiempo real

- Tolerancia a fallas a través de confirmaciones

- Fácil de operar y administrar

Contras:

- Requiere escribir bolts y spouts más complejos

- Más difícil de depurar y ajustar

- No tiene capacidades de aprendizaje automático

- Adopción y comunidad limitadas en comparación con Spark

Ejemplos del mundo real

- Webtrack DIG usa Apache Storm para procesamiento en tiempo real de miles de millones de eventos de redes sociales para detectar tendencias.

- Yieldbot construyó un motor de ofertas en tiempo real usando Storm para colocar rápidamente anuncios móviles dirigidos.

- Yahoo usa Storm para análisis en tiempo real para crear segmentos de audiencia para publicidad.

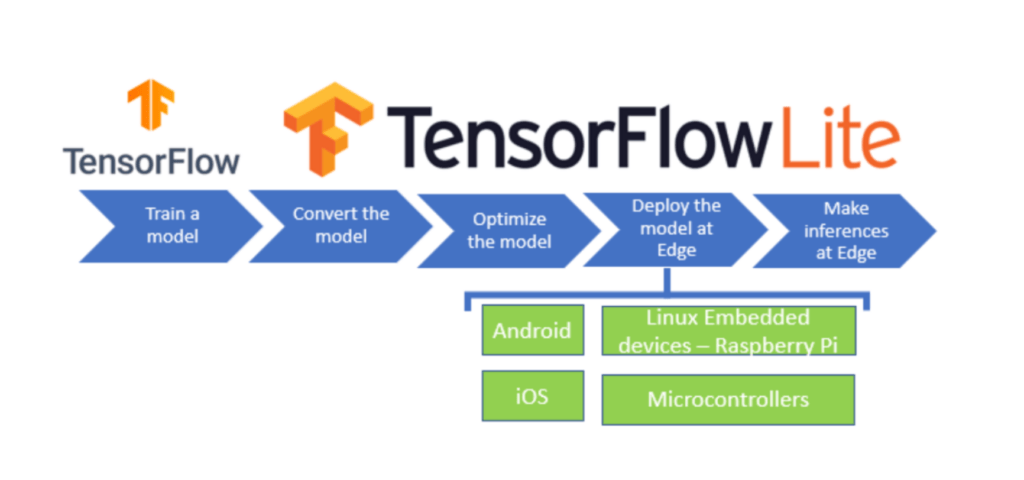

TensorFlow: Entrenamiento y despliegue de modelos de ML

Si bien no es una tecnología de big data pura, TensorFlow es una plataforma de código abierto muy popular de Google para desarrollar modelos de aprendizaje automático y entrenarlos con big data.

TensorFlow se integra perfectamente con motores de computación distribuida como Spark y plataformas de big data como Hadoop y Cassandra para aplicar análisis avanzados y algoritmos de aprendizaje automático.

Para aplicaciones IoT, TensorFlow permite construir modelos inteligentes como mantenimiento predictivo, detección de anomalías y optimización en tiempo real basada en datos de sensores.

Pros:

- Altamente escalable usando computación distribuida

- Amplio ecosistema de herramientas

- Simplifica el desarrollo de modelos de ML

- Entrenamiento y despliegue de alto rendimiento

Contras:

- Requiere habilidades especializadas en ML/IA

- Los modelos complejos pueden ser difíciles de poner en producción y mantener

- Necesita GPUs/TPUs costosos para aprendizaje profundo avanzado

Ejemplos del mundo real

- Sense360 usa TensorFlow en Spark para analizar miles de millones de puntos de datos de sensores y modelar el comportamiento del consumidor.

- Square aplica TensorFlow en datos de transacciones de clientes para proporcionar a los comerciantes información comercial personalizada y pronósticos.

- Rolls Royce entrena redes neuronales TensorFlow con datos de sensores de motores de aviones a reacción para predecir fallas.

Esto cubre las principales tecnologías de big data utilizadas para construir pipelines de datos IoT. Pero hay otras herramientas útiles como MongoDB, Amazon Kinesis, Azure Event Hubs, Druid e InfluxDB que cubren varios nichos según las necesidades arquitectónicas.

La clave es identificar la combinación adecuada de herramientas para ingerir flujos en tiempo real desde dispositivos, almacenar y procesar datos a escala, habilitar análisis en tiempo real y aplicar aprendizaje automatico.

A continuación, veamos algunas arquitecturas comunes de big data IoT que reúnen estas tecnologías…

Arquitecturas de big data IoT

Construir un pipeline de big data efectivo para IoT requiere integrar varias tecnologías de datos en una arquitectura de extremo a extremo. Existen algunos patrones arquitectónicos comunes que han surgido:

Data Lake IoT

Una arquitectura de data lake almacena datos sin procesar no estructurados de dispositivos IoT en un almacenamiento de objetos de bajo costo como HDFS o S3. Los datos se extraen, depuran y transforman más adelante para compartir en toda la organización.

Los data lakes brindan flexibilidad para explorar diversos datos. Pero se necesita gobernanza y catalogación para que los usuarios sepan qué está disponible. Los data lakes de IoT generalmente aprovechan herramientas como:

- Recolección: Kafka, Kinesis

- Almacenamiento: HDFS, S3

- Procesamiento: Spark, MapReduce, Hive

- ML: TensorFlow, PyTorch

Almacén de datos IoT

Un almacén de datos almacena datos estructurados y depurados de sistemas IoT para su uso analítico. Aplica esquemas y organización durante la ingesta. Este enfoque modelado permite consultas SQL estándar. Pero carece de flexibilidad para datos no estructurados.

Los almacenes de IoT integran motores como:

- Procesos ELT: Kafka, Spark, Flink

- DW en la nube: Redshift, BigQuery, Snowflake

- Inteligencia empresarial: Tableau, PowerBI, Looker

Arquitectura Lambda

La arquitectura Lambda combina pipelines de procesamiento de datos por lotes y en tiempo real en los mismos datos. Esto proporciona capacidades analíticas sobre datos históricos y actualizados.

- Capa por lotes: Hadoop, Spark

- Capa de velocidad: Kafka, Flink, Storm

- Capa de servicio: Cassandra, ElasticSearch

Hub IoT centralizado

Un hub de mensajería centralizado ingiere, procesa y enruta todos los datos de IoT entre dispositivos, hubs periféricos y análisis en la nube. Esto simplifica la instrumentación y la conectividad. Azure IoT Hub y AWS IoT Core ofrecen servicios administrados de hub.

- Hub de mensajería: IoT Hub, IoT Core

- Mensajería de dispositivos: MQTT, AMQP, HTTPS

- Perspectivas: Time Series Insights, Timestream

- Aplicaciones empresariales: Power BI, aplicaciones web

Análisis de borde IoT

La computación de borde acerca el procesamiento a los dispositivos IoT para obtener información más rápido y reducir los flujos de datos a la nube. Esto actúa como un filtro, enviando solo datos útiles para almacenamiento y análisis de mayor nivel.

- Computación de borde: Azure Stack Edge, AWS Outposts

- Brokers de mensajes: MQTT, AWS IoT Greengrass

- Análisis de borde: Azure Stream Analytics, Spark

- Integración en la nube: Event Hubs, IoT Hub, Kafka

Elementos clave de un pipeline de big data IoT

Ahora que hemos visto los enfoques arquitectónicos comunes, analicemos los elementos clave que componen un pipeline de big data para IoT:

Ingesta de datos

- Recopilar y transportar flujos de datos desde dispositivos IoT a la plataforma de datos de manera confiable y sin pérdida de datos.

- Tecnologías como Kafka y Kinesis manejan la transferencia de flujos con escalabilidad, baja latencia y durabilidad.

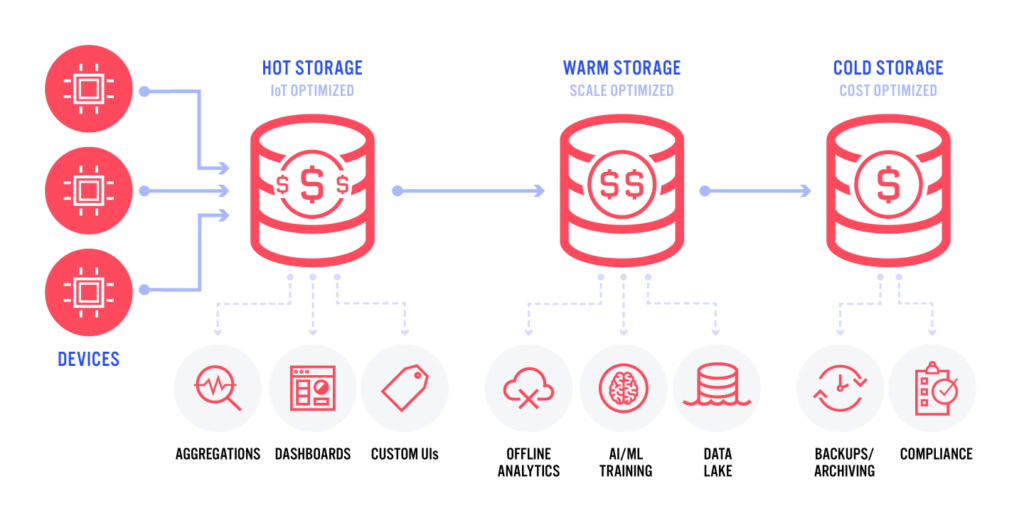

Almacenamiento de datos

- Los datos sin procesar de los dispositivos IoT deben almacenarse para su posterior procesamiento y archivo a largo plazo.

- Los sistemas de almacenamiento distribuido como Hadoop y Cassandra permiten almacenar eficientemente enormes cantidades de datos.

Procesamiento de flujo

- Analizar los datos en movimiento en tiempo real a medida que llegan de los dispositivos IoT antes de almacenarlos para su posterior procesamiento por lotes.

- Herramientas como Spark Streaming y Flink permiten un procesamiento de flujo complejo con milisegundos de latencia.

Procesamiento por lotes

- Procesar lotes históricos de datos recopilados para detectar patrones, agregaciones y entrenar modelos de aprendizaje automático.

- Hadoop proporciona un procesamiento por lotes masivamente paralelo en clústeres.

Análisis de datos

- Una vez procesados, los datos deben analizarse y visualizarse para extraer información.

- Las consultas SQL, los tableros y los cuadernos ayudan a analizar los datos IoT almacenados.

Aprendizaje automático

- Con datos IoT ricos, se puede aplicar aprendizaje automático para análisis predictivo y optimización.

- TensorFlow se integra con herramientas de big data para permitir el desarrollo de modelos escalables.

Este pipeline transforma los datos IoT sin procesar en información valiosa. Veamos a continuación cómo la nube puede ayudar a acelerar la construcción y escalado del pipeline.

Aprovechando los servicios administrados en la nube

Si bien las tecnologías de big data de código abierto proporcionan los cimientos fundamentales para un pipeline de datos IoT, gestionar la infraestructura y las herramientas puede ser complejo. Aquí es donde aprovechar los servicios administrados en la nube puede ayudar a simplificar y acelerar el análisis de IoT.

He aquí algunos ejemplos de servicios administrados en la nube que reducen las cargas operativas:

- Amazon Kinesis – Transmisiones de datos totalmente administradas para ingesta y procesamiento de datos

- Google BigQuery – Almacén de datos serverless para análisis a escala

- Azure Event Hubs – Ingesta de eventos en tiempo real para datos de streaming

- Amazon EMR – Clústeres de Hadoop y Spark alojados en la nube

- AWS Glue – ETL y integración de datos totalmente serverless

Al aprovechar estos servicios de plataforma, las empresas pueden centrarse menos en las herramientas y la infraestructura y más en sus casos de uso analíticos centrales y aplicaciones. La nube también proporciona escalabilidad elástica para manejar los picos en los datos IoT.

Por supuesto, al depender de los servicios en la nube, es fundamental garantizar el cumplimiento normativo, contar con disposiciones de recuperación ante desastres y bloquear las configuraciones de seguridad.

Ideas clave IoT y Big Data

Para resumir, aquí hay algunas ideas clave para aprovechar con éxito las tecnologías de big data para IoT:

- Planificar la escala y el crecimiento al diseñar la arquitectura: los volúmenes de datos crecen rápidamente.

- Ingerir y procesar flujos en tiempo real para impulsar insights instantáneos.

- Almacenar datos sin procesar para análisis futuros y aprendizaje automático.

- Combinar pipelines por lotes y en tiempo real para datos históricos y actuales.

- Mezclar tecnologías de código abierto con servicios administrados en la nube.

- Centrarse en impulsar insights valiosos en lugar de solo recopilar datos.

- Facilitar el acceso a los datos para los usuarios a través de API y herramientas.

- Implementar una gobernanza de datos y seguridad sólidas de extremo a extremo.

Conclusión IoT y Big Data

Los enormes datos generados por el Internet de las Cosas tienen el potencial de brindar beneficios transformadores en diversas industrias, desde la optimización de la cadena de suministro hasta el mantenimiento predictivo y la atención médica personalizada. Pero aprovechar el poder de los datos de IoT requiere construir pipelines de big data sólidos capaces de ingerir, almacenar, procesar y analizar enormes flujos de datos en tiempo real.

Como hemos visto, ha surgido un ecosistema tecnológico que permite construir arquitecturas de datos IoT escalables, entre ellas:

- Ingestión de datos – Kafka, Kinesis

- Almacenamiento – Hadoop, Cassandra, S3

- Procesamiento de flujos – Spark, Flink, Storm

- ML y análisis – TensorFlow, Presto, Looker

Estas tecnologías proporcionan los componentes centrales para un pipeline de datos IoT. Sin embargo, aprovechar plenamente el valor de los datos de IoT sigue siendo un desafío. Las organizaciones deben reunir la combinación adecuada de herramientas, infraestructura en la nube, habilidades internas y prioridades comerciales.

Los aspectos clave incluyen:

- Combinar pipelines en tiempo real y por lotes

- Aprovechar los servicios administrados en la nube

- Construir pensando en la escala y extensibilidad futuras

- Habilitar el acceso fácil a los datos a través de API

- Enfocar el análisis en resultados comerciales claros

Con una base de big data sólida en su lugar, los datos de IoT pueden proporcionar una visibilidad revolucionaria en los sistemas y procesos, impulsando la toma de decisiones basada en datos. Todavía estamos en las primeras etapas de que las organizaciones aprovechen los datos de IoT a escala. A medida que las arquitecturas maduren y se vuelvan más integradas, los datos de IoT desencadenarán revoluciones generalizadas en diversas industrias.

El futuro sin duda traerá una proliferación de dispositivos interconectados y flujos de datos cada vez mayores. Las organizaciones que construyan plataformas adaptables para aprovechar estos datos hoy obtendrán una ventaja competitiva sostenible. Espero que esta guía brinde una visión práctica de las tecnologías que hacen posible esta nueva realidad impulsada por los datos.

Puedes encontrar más artículos interesantes en el blog.