Los modelos generativos profundos son una de las áreas más emocionantes de la investigación en inteligencia artificial hoy en día. Estos modelos son capaces de generar nuevos datos similares a los datos en los que se han entrenado, lo que les permite producir resultados de alta calidad como imágenes, audio y texto. En los últimos años, las técnicas de aprendizaje profundo han llevado a avances significativos en modelos generativos, produciendo modelos que pueden generar resultados increíblemente realistas y diversos. En este artículo a fondo, echaremos un vistazo en profundidad a los modelos generativos profundos de vanguardia en diferentes tipos de datos y áreas de aplicación.

Contenidos: modelo generativo profundo

Descripción general de los modelos generativos

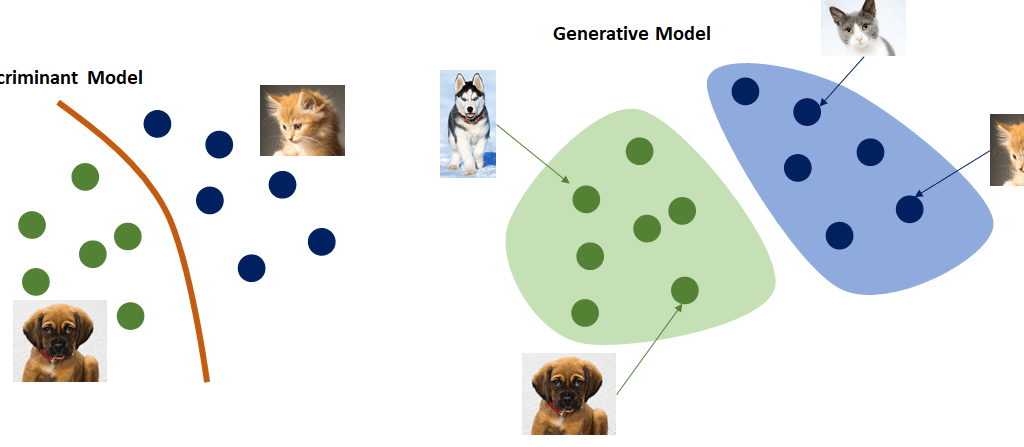

Los modelos generativos son modelos que pueden aprender la distribución estadística de los datos de entrenamiento y generar nuevos puntos de datos de esa distribución aprendida. Esto les permite crear nuevos datos sintéticos similares a los datos en los que se entrenaron. Algunos tipos de modelos generativos incluyen:

- Redes generativas antagónicas (GAN) – Dos redes neuronales compiten entre sí para volverse mejores en la generación de resultados realistas.

- Autoencoders variacionales (VAE) – Aprenden una representación latente de los datos que se puede muestrear para generar nuevos resultados.

- Modelos autorregresivos – Generan datos secuencialmente una parte a la vez en función de la porción generada anteriormente.

- Modelos basados en flujo – Usan una serie de transformaciones reversibles para modelar y generar datos.

Los modelos generativos tienen una amplia gama de casos de uso, que incluyen:

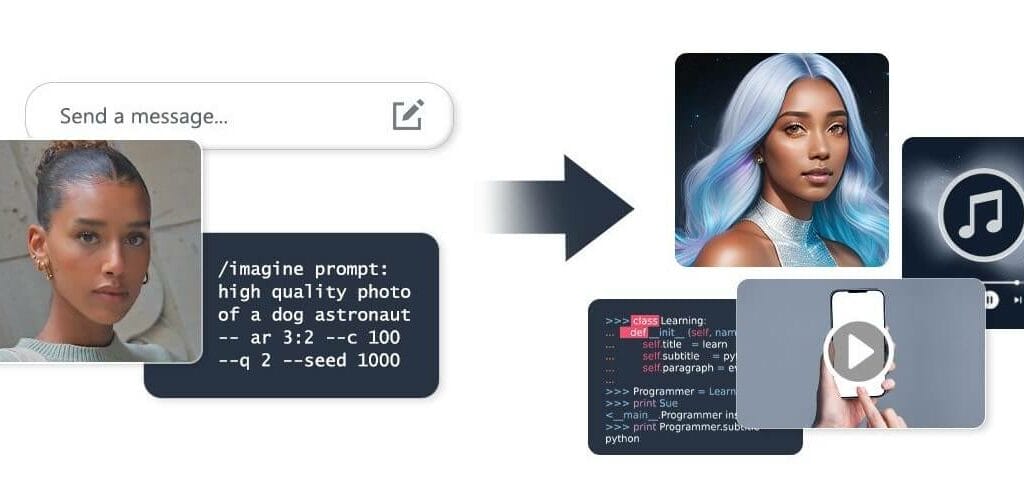

- Generación de imágenes: creación de imágenes y obras de arte fotorrealistas.

- Generación de texto: producción de texto sintético para aplicaciones como traducción y escritura creativa.

- Generación de audio: generación de música, voz y otros audios.

- Descubrimiento de fármacos: diseño u optimización de estructuras moleculares.

- Detección de anomalías: detección de puntos de datos anómalos modelando la distribución normal de datos.

En los últimos años, las técnicas de aprendizaje profundo han permitido la creación de modelos generativos que producen resultados notablemente realistas y de alta calidad. El uso de técnicas como redes neuronales convolucionales y recurrentes, atención, memoria y modelos de transformador ha llevado a avances significativos en las capacidades de los modelos generativos en diferentes tipos de datos.

En el resto de este artículo, profundizaremos en algunos de los modelos generativos profundos de vanguardia para tipos de datos y aplicaciones clave.

Modelos generativos profundos de vanguardia para imágenes

Redes generativas antagónicas (GAN)

Las GAN han surgido como un marco poderoso para entrenar modelos generativos para la síntesis de imágenes. Presentadas por primera vez en 2014, las GAN funcionan entrenando dos redes neuronales: un generador y un discriminador en competencia. El generador intenta producir imágenes sintéticas cada vez más realistas, mientras que el discriminador intenta distinguir entre las imágenes generadas y las imágenes reales del conjunto de datos de entrenamiento. Esta competencia antagónica fuerza a que las imágenes generadas se vuelvan indistinguibles de las imágenes reales.

Muchas innovaciones de impacto en la generación de imágenes han surgido de ajustes y mejoras en el marco GAN original:

- DCGAN: la GAN convolucional profunda agregó capas convolucionales para permitir que las GAN funcionen bien con datos de imagen.

- CycleGAN: puede aprender a traducir entre dos dominios visuales sin datos de entrenamiento emparejados.

- StyleGAN: presentó una arquitectura de generador basada en estilo que logra resultados líderes en calidad de síntesis de imágenes, variación y resolución.

- BigGAN: escaló el entrenamiento de GAN utilizando grandes lotes y más poder informático para lograr un nivel sin precedentes de calidad de imagen y variación para las imágenes generadas.

Modelos autorregresivos para generación de imagénes

Los modelos autorregresivos generan imágenes píxel por píxel modelando la distribución condicional de cada píxel dados los píxeles anteriores. Ejemplos prominentes incluyen:

- PixelCNN: utiliza una red neuronal convolucional para modelar las distribuciones de píxeles y generar imágenes.

- Image Transformer: aplica la arquitectura transformer comúnmente utilizada en PLN para un mejor modelado de las dependencias de largo alcance entre píxeles.

- DALL-E: un modelo de texto a imagen que utiliza un decodificador transformer para generar imágenes a partir de descripciones textuales.

Modelos de difusión

Los modelos de difusión han surgido recientemente como un enfoque líder para la generación de imágenes de alta fidelidad. Estos modelos funcionan comenzando con una imagen y agregando ruido a ella gradualmente en varios pasos. El modelo se entrena para revertir este proceso de difusión, paso a paso desde el ruido hasta una imagen impecable. Esto permite el muestreo de imágenes de alta calidad a partir de vectores de ruido. Los ejemplos incluyen:

- DDPM: el Modelo de difusión probabilística desanublante original introducido por Ho et al. en 2020.

- DDIM: el Modelo de difusión con velocidad de muestreo mejorada.

- GLIDE: un modelo de difusión condicional al texto que genera imágenes fotorrealistas a partir de descripciones textuales.

Evaluación del progreso en la generación de imágenes

El progreso en el modelado generativo de imágenes se evalúa comúnmente utilizando métricas como la distancia de Fréchet Inception (FID), que mide la diferencia entre las distribuciones de imágenes generadas y reales. Un FID más bajo indica mayor realismo. En esta métrica, modelos recientes como Imagen han logrado puntajes FID comparables a imágenes reales de conjuntos de datos como CIFAR-10.

La puntuación de Inception (IS) es otra métrica que mide tanto la calidad de la imagen como la diversidad. Puntuaciones más altas indican una variación más realista en las imágenes generadas. BigGAN logró puntuaciones récord de IS en conjuntos de datos como ImageNet cuando se publicó.

La evaluación humana sigue siendo un complemento importante para cuantificar el realismo, la coherencia y la diversidad al medir el progreso en la generación de imágenes. Pero las métricas automatizadas permiten una comparación eficiente entre modelos y puntos de referencia en conjuntos de datos estándar.

Modelos líderes para la generación de texto

La generación de texto ha visto un rápido progreso gracias a los avances en el aprendizaje profundo y el uso de modelos de lenguaje preentrenados a gran escala. Aquí examinamos algunos modelos líderes para diferentes tareas de generación de texto:

Modelos de lenguaje autorregresivos

Los modelos autorregresivos generan texto prediciendo un token a la vez, acondicionando cada token en tokens anteriores. Ejemplos prominentes incluyen:

- GPT-3: un gran modelo de transformador preentrenado en enormes cantidades de datos de texto. Logra un fuerte rendimiento en la generación de texto para una variedad de aplicaciones.

- Meena: un modelo conversacional entrenado por Google usando 2.6 mil millones de parámetros. Puede mantener conversaciones fluidas y coherentes.

Modelos de texto a texto

Los modelos de texto a texto se entrenan para generar texto objetivo condicionado en texto fuente de entrada. Los ejemplos incluyen:

- T5: el modelo de transferencia de transformador de texto a texto de Google que está preentrenado en una mezcla de múltiples tareas de texto y se puede ajustar para diversas aplicaciones de generación.

- BART: el autoencoder de deconstrucción de Facebook para preentrenar modelos seq2seq. Está diseñado para tareas generativas como la generación de resúmenes de texto.

- PEGASUS: un modelo autorregresivo preentrenado en oraciones con espacios derivadas de corpus de texto. Logra el estado del arte en tareas de resumen.

Evaluación de la generación de texto

Las métricas de evaluación para la generación de texto incluyen:

- Perplejidad: mide qué tan bien predice una muestra un modelo. Menor perplejidad indica mejor calidad de generación.

- BLEU: compara texto generado con textos de referencia mediante la superposición de n-gramas. Útil para resultados estructurados como resúmenes.

- ROUGE: mide la superposición entre resúmenes generados y de referencia mediante el uso de n-gramas y secuencias comunes más largas.

- Evaluación humana: calificación de texto generado para precisión, fluidez, coherencia y diversidad a través de encuestas.

Recientemente, enfoques humano-IA colaborativos como el entrenamiento con humanos en el circuito han demostrado ser prometedores para mejorar la calidad de la generación de texto.

Modelos líderes para la generación de voz y audio

La modelización generativa de audio, especialmente del habla, también ha visto avances significativos a través del aprendizaje profundo. Los enfoques clave incluyen:

Modelos autorregresivos en generación de voz y audio

Los modelos autorregresivos como WaveNet generan audio una muestra a la vez en función de muestras anteriores.

- WaveNet: un modelo autorregresivo seminal desarrollado por DeepMind que logró una generación de voz de alta fidelidad al modelar formas de onda.

- WaveRNN: una versión más rápida que usa redes recurrentes en lugar de convoluciones, mejorando la calidad del audio.

GAN para audio

Las GAN también se pueden adaptar para la generación de audio entrenando en representaciones de audio de dominio de tiempo o espectrogramas.

- MelGAN: un modelo GAN que opera directamente en formas de onda de audio en bruto para sintetizar voz de alta fidelidad.

- StyleGAN-NADA: aplica StyleGAN para generar espectrogramas de alta resolución que se invierten a audio. Permite controlar el estilo/timbre de la música generada.

Vocoders

Los vocoders convierten representaciones de espectrogramas nuevamente en formas de onda de dominio de tiempo. Son componentes críticos de muchos sistemas de generación de voz, incluido TTS.

- WaveNet Vocoder: una variante de vocoder de WaveNet que mejoró la calidad del habla para TTS.

- Parallel WaveGAN: usa un modelo GAN para vocodificación para lograr una síntesis de voz rápida y de alta fidelidad a partir de mel-espectrogramas.

- HiFiGAN: combina GAN, modelos autorregresivos y entrenamiento antagónico para el estado del arte actual en calidad de vocoder.

Evaluación de la generación de audio

Las métricas para evaluar la calidad de la generación de audio incluyen:

- Puntuación de opinión media (MOS): calificación humana del audio generado en una escala de 1-5 según la calidad.

- Distorsión cepstral de Mel (MCD): mide la distorsión entre los mel-espectrogramas generados y reales.

- Distancia Fréchet DeepSpeech (FDSD): equivalente de audio de FID que utiliza características de DeepSpeech.

- Distancia Kernel DeepSpeech (KDSD): prueba la diversidad de muestras midiendo la variabilidad de características de DeepSpeech.

El MOS con calificadores humanos sigue siendo el estándar de oro para evaluar el progreso. Las métricas automatizadas proporcionan una comparación más fácil entre modelos.

Modelos líderes para productos químicos y materiales

La capacidad de generar nuevas estructuras moleculares y simulaciones de materiales con propiedades deseables tiene aplicaciones prometedoras en química, descubrimiento de fármacos y física cuántica. Aquí examinamos algunos modelos generativos líderes en este dominio:

Moléculas pequeñas

- GCPN: una red de políticas convolucionales gráficas que puede generar gráficos moleculares de manera eficiente con alta validez y diversidad.

- MolGAN: una GAN que opera en representaciones de gráficos moleculares para producir moléculas pequeñas similares a fármacos.

- JT-VAE: un modelo de autoencoder de variación que aprovecha la representación de gráfico de árbol de unión para mejorar la generación molecular.

Proteínas

- Aprendizaje por refuerzo: modelos entrenados a través de RL para generar secuencias de aminoácidos que se pliegan en estructuras proteicas objetivo.

- LANTERN: utiliza un modelo de lenguaje de transformador ajustado en secuencias de proteínas para generar diseños de proteínas diversos y válidos.

- AlphaFold: aunque no es generativo, este modelo revolucionario de predicción de estructura está permitiendo avances en la generación de proteínas.

Química cuántica

- SchNet: una arquitectura de red neuronal profunda que utiliza capas convolucionales de filtro continuo para modelar interacciones y propiedades cuánticas de sistemas moleculares.

- FermiNet: genera aproximaciones rápidas de los estados fundamentales de sistemas cuánticos fermiónicos, permitiendo una simulación eficiente.

- MPNN: las redes neuronales de paso de mensajes pueden aprender a simular interacciones cuánticas para la dinámica molecular.

Métricas de evaluación

Las métricas clave para evaluar modelos generativos de productos químicos y materiales incluyen:

- Validez: porcentaje de salidas válidas y estables según las restricciones del dominio.

- Novedad: evaluación de la disimilitud estructural y diversidad en comparación con los datos de entrenamiento.

- Optimización de propiedades deseadas: evaluar si los modelos generan salidas con valores objetivo para propiedades como similitud a fármacos, bandgap, etc.

- Precisión cuántica: comparación de predicciones de energía y propiedades con simulaciones y experimentos de física real.

Modelos generativos de vanguardia para datos 3D

El modelado y la generación de datos 3D como nubes de puntos, mallas y vóxeles es una frontera emergente para modelos generativos con aplicaciones que van desde RA/RV hasta robótica.

Generación de nube de puntos 3D

- PointGrow: utiliza modelado autorregresivo para generar nubes de puntos 3D de alta calidad.

- PointCloudGAN: un modelo GAN que puede sintetizar nuevas formas y estilos de nube de puntos.

Generación de malla 3D

- Pixel2Mesh: utiliza convoluciones gráficas dentro de un modelo VAE para generar mallas 3D a partir de imágenes.

- GRNet: aprovecha redes neuronales gráficas y redes convolucionales de ocupación para la generación de mallas de alta calidad.

Síntesis de nueva vista

- PIFu: permite sintetizar una imagen de persona desde nuevos puntos de vista basándose en una única imagen de entrada mediante el uso de funciones implícitas alineadas por píxeles.

- GRAF: genera nuevas vistas de escenas utilizando campos de radiación generativos, construyendo en NeRF.

Métricas de evaluación 3D

Las métricas clave para evaluar modelos generativos 3D incluyen:

- Distancia de nube de puntos de Fréchet: extiende FID para comparar distribuciones de nubes de puntos 3D.

- Medidas de distancia de malla: como distancia de Chamfer, distancia de Hausdorff y volumen de intersección de malla para evaluar la similitud de mallas generadas frente a reales.

- LPIPS: mide la similitud perceptual entre imágenes sintetizadas y reales para la evaluación de nuevas vistas.

- Evaluación humana: calificación del realismo, consistencia y coherencia de las salidas 3D generadas.

Aplicaciones novedosas y emergentes de modelos generativos

Ahora que hemos cubierto el estado del arte en modelos generativos para los principales tipos de datos, echemos un vistazo a algunas aplicaciones novedosas y emergentes que aprovechan los últimos modelos generativos profundos:

Aplicaciones creativas

- Arte y diseño asistidos por IA: creación, aumento y mejora de obras de arte visuales, animaciones, conceptos arquitectónicos, diseño industrial, etc.

- Generación de contenido procedural: generación automática de texturas, mundos 3D, personajes y narrativas para juegos.

- Composición musical: composición de melodías, acompañamientos y canciones completas originales desde cero.

Descubrimiento de conocimiento

- Generación de moléculas para descubrimiento de fármacos: diseño u optimización de estructuras moleculares con propiedades farmacológicas deseadas.

- Diseño de proteínas de novo: creación de nuevas estructuras de proteínas con aplicaciones para terapéutica y biomateriales.

- Ciencia basada en simulación: uso de simulaciones y modelos sustitutos generados para obtener información sobre sistemas físicos.

Generación de datos sintéticos

- Aumento de datos: creación de datos de entrenamiento variados a partir de muestras limitadas para tareas como clasificación de imágenes.

- Conjuntos de datos anonimizados: generación de registros de salud de pacientes sintéticos para investigación.

- Sim2Real: uso de imágenes simuladas para mejorar el rendimiento en tareas de imágenes reales.

Manipulación de medios y contenido

- Deepfakes: intercambio de caras o manipulación completa de imágenes/videos para entretenimiento o desinformación.

- Transferencia de estilo de texto: modificación de texto para tener diferentes estilos, perspectivas, sentimientos, etc. preservando el contenido.

- Edición multimedia: permitiendo una edición fluida entre modalidades de imagen, audio, texto.

Principales desafíos y direcciones para modelos generativos

Si bien se ha logrado un rápido progreso recientemente en el modelado y síntesis generativa, quedan considerables desafíos y fronteras para seguir avanzando:

Abordar sesgos, privacidad y mal uso

- Los modelos generativos corren el riesgo de perpetuar y amplificar los sesgos sociales presentes en los datos de entrenamiento. Se requiere investigación continua sobre técnicas de reducción de sesgos.

- La creación de medios sintéticos plantea preocupaciones sobre desinformación, uso no autorizado y violaciones de la privacidad. Se necesitan métodos para detectar contenido sintético.

- Se necesitan transparencia, marcos de gobernanza y compromiso público en torno a los casos de uso para guiar éticamente el progreso en modelos generativos.

Mejorar la eficiencia del entrenamiento

- El preentrenamiento de modelos generativos complejos actualmente requiere recursos computacionales masivos no siempre accesibles para organizaciones más pequeñas. Técnicas de entrenamiento más eficientes podrían ayudar a democratizar el progreso.

- Explorar alternativas al entrenamiento de máxima verosimilitud, como la estimación de contraste de ruido y nuevas funciones de pérdida teóricas, puede permitir una convergencia más rápida.

- Los métodos de destilación para comprimir modelos preentrenados sin perder demasiada calidad de generación también garantizan más investigación.

Mejora del control y la predictibilidad

- Equilibrar la fidelidad de imágenes/audio y la coherencia con la controlabilidad y las salidas predecibles de los modelos sigue siendo un desafío abierto.

- Mejora de técnicas como manipulación de espacio latente, generación condicional y atención dispersa para lograr un control de grano fino sobre modelos generativos.

- Aumentar la interpretabilidad de los patrones de atención del modelo y las representaciones de características podría ayudar a la predictibilidad.

Extender modelos a más modalidades

- La mayoría del progreso se ha centrado en imágenes, audio y texto. Expandirse a modalidades como video, entradas multimodales y datos estructurados en gráficos ofrece posibilidades.

- Combinar perspectivas de visión, lenguaje, robótica y sistemas de recomendación podría permitir arquitecturas generativas más flexibles y potentes.

- Lograr una generación coherente cross-modal, por ejemplo, salidas de imagen-texto alineadas, es un problema abierto que requiere más innovación.

Perspectivas

La rápida evolución de los modelos generativos profundos representa una de las fronteras más emocionantes de la IA actual. Los modelos continúan alcanzando capacidades sin precedentes en la síntesis de resultados de alta fidelidad y diversos que abarcan imágenes, audio, química, 3D y más. Al mismo tiempo, los desafíos permanecen en torno a sesgos, eficiencia, control y extensión de modelos a nuevas modalidades y aplicaciones. Abordar estos problemas abiertos mientras se abordan proactivamente las preocupaciones éticas será crucial para orientar estas poderosas tecnologías generativas hacia usos ampliamente beneficiosos y prevenir el mal uso a medida que avanza este campo.

Ideas principales

- Los modelos generativos aprenden representaciones de datos que permiten el muestreo de nuevos puntos de la distribución. GAN, VAE, modelos autorregresivos y de difusión son enfoques líderes.

- Para imágenes, destacan modelos generativos como StyleGAN, BigGAN, DALL-E y DDPM que pueden producir imágenes muy realistas y diversas.

- GPT-3, T5, BART y otros modelos de transformador basados en lenguaje son los líderes para la generación de texto en diversas aplicaciones.

- WaveNet, MelGAN y WaveGAN paralelo son modelos líderes para la generación de voz y música de alta fidelidad.

- Para productos químicos, redes convolucionales gráficas, GAN y VAE moleculares y modelos de aprendizaje por refuerzo están avanzando en la generación molecular.

- Los modelos de nube de puntos, malla y síntesis de nueva vista están impulsando el estado del arte en modelado generativo de datos 3D.

- Las aplicaciones emergentes abarcan desde el descubrimiento de fármacos hasta la generación creativa de medios, el descubrimiento de conocimiento, los datos sintéticos y la manipulación de contenido.

- Los desafíos clave permanecen en torno a sesgos, eficiencia, controlabilidad, nuevas modalidades e implicaciones éticas.

Conclusión

En conclusión, los modelos generativos profundos basados en redes neuronales han avanzado enormemente en su capacidad para sintetizar resultados realistas y de alta calidad en modalidades como imágenes, audio y formas 3D. Están impulsando el progreso en aplicaciones creativas desde la generación de medios hasta el diseño de fármacos, al tiempo que plantean consideraciones importantes sobre ética y uso responsable. Las innovaciones clave en aprendizaje antagónico, modelado secuencial, representaciones latentes y más continúan alimentando el progreso emocionante en este campo central de la IA.

Puedes encontrar más artículos interesantes sobre inteligencia artificial en nuestro blog.